En ocasiones los investigadores y especialistas en ciberseguridad no detectan las fallas de seguridad en algunos desarrollos tecnológicos hasta que estos llegan al mercado. En los peores casos, los primeros en detectar estas fallas o agujeros de seguridad son los actores de amenazas, por lo que la labor de los investigadores y firmas de seguridad es vital para corregir estas fallas antes de que sean explotadas.

Recientemente, un equipo de investigadores de la Universidad Ben-Gurion, en Israel, publicó un informe detallando una falla de seguridad en los sistemas de piloto automático empleados en diversos autos inteligentes, incluyendo el Tesla Model X. Acorde a los investigadores, es posible emplear un dron y un mini proyector para engañar a estos sistemas de navegación, proyectando imágenes falsas en el camino o en vallas publicitarias aledañas.

La explotación de estas fallas de seguridad generaría la activación imprevista de los frenos del auto o, en otros casos, cambios repentinos en el curso del auto, comprometiendo la integridad física de los ocupantes. Para las pruebas, los expertos en ciberseguridad emplearon un Tesla Model X, además de un sistema avanzado de asistencia de manejo (ADAS) del fabricante Mobileye.

Engañando a los sistemas de conducción automática

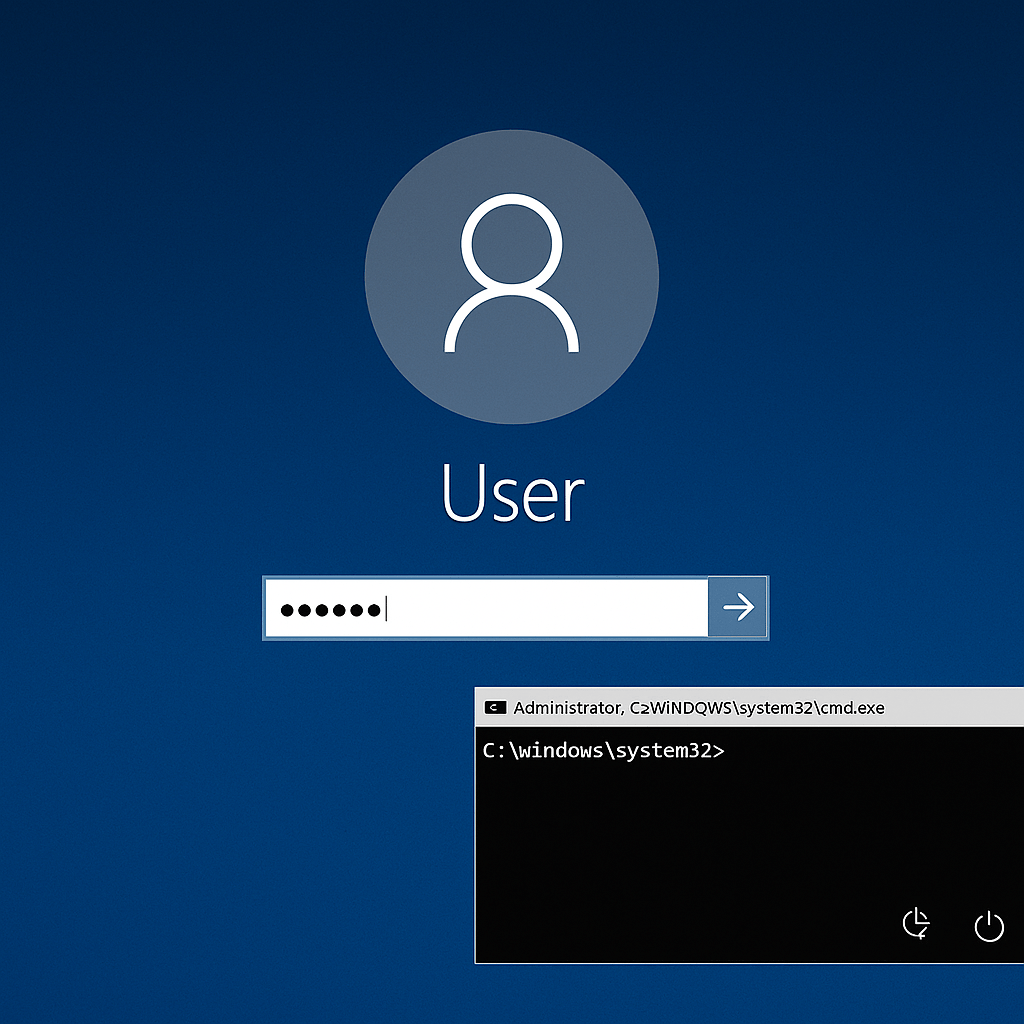

Mire con atención la siguiente imagen; ¿considera que lo que está viendo es real?

Pues tanto el Tesla Model X y el sistema Mobileye 630 PRO identificaron como reales las imágenes proyectadas, lo que forzó a un cambio en su operación real.

Los investigadores se refieren a estas imágenes como “fantasmas”; objetos sin profundidad que los sistemas ADAS y de piloto automático perciben y consideran como un objeto físico real. Las proyecciones pueden variar, incluyendo imágenes de personas, de otros autos, señales de tránsito o carriles en el asfalto.

Durante el experimento, los expertos en ciberseguridad emplearon un mini proyector montado en un dron. La proyección de los fantasmas tomó apenas 125 milisegundos, suficiente para hacer que el Tesla Model X se desviara del curso original.

Estas proyecciones también pueden forzar el frenado repentino del Tesla Model X. A continuación, se aprecia cómo el auto reduce su velocidad notablemente después de que el sistema de manejo automático detectara uno de estos fantasmas, identificándolo como una persona real.

Si bien la explotación de estas fallas es compleja, es necesario considerar algunas medidas de seguridad. Acorde a los expertos en ciberseguridad, una forma de mitigar el riesgo de explotación es configurar los sistemas ADAS para que tomen en cuenta factores como la luz reflejada en los objetos y la superficie, obteniendo una mejor detección de los objetos reales y las proyecciones sin profundidad.

Esta no es la primera ocasión en la que se detectan fallas de seguridad en un auto conectado. Hace un par de años, el Instituto Internacional de Seguridad Cibernética (IICS) reportó un agujero de seguridad en una Jeep Cherokee que permitía a los atacantes tomar control de los sistemas críticos del auto, por lo que múltiples modelos tuvieron que ser sacados del mercado.

Trabajando como arquitecto de soluciones de ciberseguridad, Alisa se enfoca en la protección de datos y la seguridad de datos empresariales. Antes de unirse a nosotros, ocupó varios puestos de investigador de ciberseguridad dentro de una variedad de empresas de seguridad cibernética. También tiene experiencia en diferentes industrias como finanzas, salud médica y reconocimiento facial.

Envía tips de noticias a info@noticiasseguridad.com o www.instagram.com/iicsorg/

También puedes encontrarnos en Telegram www.t.me/noticiasciberseguridad