Un trabajo en conjunto de profesionales en seguridad informatica chinos y estadounidenses encontró un método nuevo para atentar contra los asistentes personales inteligentes como Amazon Alexa y Google Home, a los que nombraron “voz en cuclillas”.

Los expertos detallaron la técnica en un documento de investigación recientemente publicado, junto con otro método de ataque llamado enmascaramiento de voz.

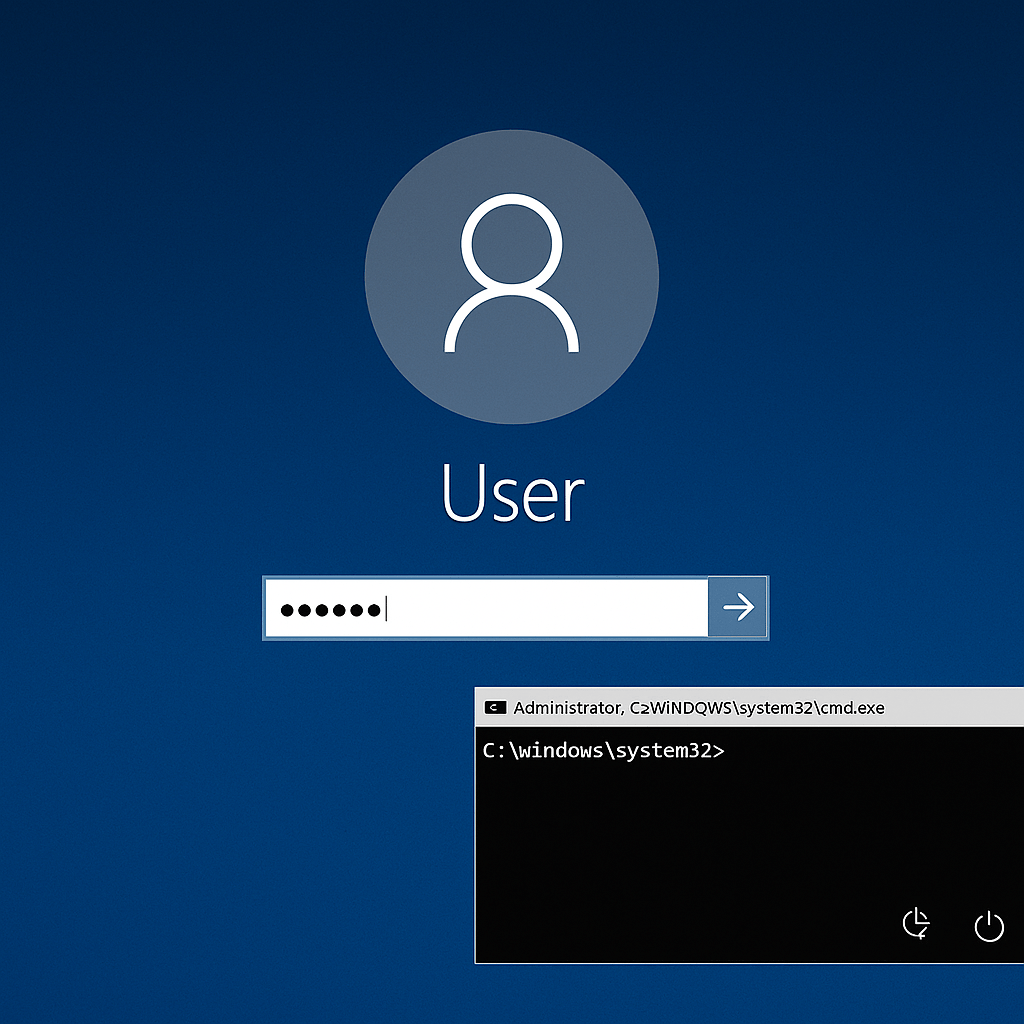

Los actores maliciosos tratan de engañar a los usuarios para que abran una aplicación infectada usando desencadenadores de voz similares a los de las aplicaciones auténticas, también usan estas aplicaciones infectadas para obtener datos confidenciales o para espiar a su alrededor.

El primer ataque se llama “poner en cuclillas de voz”, se basa en las similitudes entre los comandos de voz que desencadenan acciones específicas, comentan los expertos en seguridad informatica.

El equipo de investigadores encontró, que podían registrar aplicaciones de asistente de voz, llamadas “habilidades” por Amazon y “acciones” por Google, que activan frases muy parecidas.

Los investigadores comentaron que un atacante podría, por ejemplo, registrar una aplicación que se desencadena con la frase “open capital won”, que es fonéticamente similar a “open capital one”, el comando para abrir la aplicación de banca Capital One para asistentes de voz.

Este tipo de ataque no funcionara todo el tiempo, pero es más probable que funcione para hablantes no nativos de inglés que tengan un acento, o para entornos en donde hay mucho ruido y el comando pueda malinterpretarse.

De la misma manera, un atacante podría registrar una aplicación maliciosa que se desencadena por “open capital one please” o variaciones en las que el actor malicioso agrega palabras al activador.

Existen videos en donde se demuestran ataques de cuclillas de voz en dispositivos Amazon Alexa y Google Home.

En cuanto al ataque de enmascaramiento de voz; sabemos que no es nuevo y ya se ha detallado en diferentes investigaciones.

La idea de este ataque es prolongar el tiempo de interacción de una aplicación en ejecución, pero sin que lo note el usuario, comentaron expertos en seguridad informatica.

El propietario del dispositivo cree que la aplicación anterior (la maliciosa) ha dejado de trabajar, pero la aplicación sigue escuchando los comandos. En el momento en que el usuario intenta interactuar con otra aplicación legítima, la maliciosa responde con su propia interacción falsa.

Los profesionales dicen que los ataques de enmascaramiento de voz son ideales para los usuarios de phishing.

Expertos en seguridad informatica nos dicen que si se quiere conocer mas de este ataque, existen videos de demos disponibles en un sitio web dedicado, y también hay más detalles sobre la investigación en un documento titulado “”Understanding and Mitigating the Security Risks of Voice-Controlled Third-Party Skills on Amazon Alexa and Google Home”.

El equipo de expertos contactó a Amazon y Google con los hallazgos de su investigación, y comentaron que ambas compañías están investigando las vulnerabilidades.

Entusiasta de la seguridad cibernética. Especialista en seguridad de la información, actualmente trabajando como especialista en infraestructura de riesgos e investigador.

Experiencia en procesos de riesgo y control, soporte de auditoría de seguridad, diseño y soporte de COB (continuidad del negocio), gestión de grupos de trabajo y estándares de seguridad de la información.

Envía tips de noticias a info@noticiasseguridad.com o www.instagram.com/iicsorg/.

También puedes encontrarnos en Telegram www.t.me/noticiasciberseguridad